مدل MIT لینکلن گروه آزمایش هوش و تصمیم گیری گروه استاندارد جدیدی را برای درک اینکه چگونه یک شبکه عصبی تصمیم میگیرد، تعیین میکند.

یک کودک با یک تصویر از اشکال مختلف روبرو میشود و از او خواسته شده است که دایره قرمز بزرگ را پیدا کند. برای رسیدن به پاسخ، او از طریق چند مرحله از استدلال میرود: اول، همه چیزهای بزرگ را پیدا میکند.

ما از طریق دلیل یاد میگیریم که چگونه جهان را تفسیر کنیم. بنابراین، شبکه های عصبی را نیز انجام دهید. در حال حاضر محققان از گروه فناوری اطلاعات و تصمیم گیری آزمایشگاه لینکلن MIT یک شبکه عصبی ایجاد کرده است که مراحل استدلال انسانی را برای پاسخ به سوالات در مورد محتویات تصاویر انجام میدهد. مدل Transparency by Design Network (TbD-net) نامگذاری شده است، مدل بصری پردازش های تفکر خود را ارائه میدهد و مشکلات را حل میکند و اجازه میدهد تحلیل گران انسانی تصمیم گیری خود را تفسیر کنند. این مدل بهتر از بهترین شبکه های عصبی مصنوعی بصری است.

درک اینکه چگونه یک شبکه عصبی به تصمیماتش میرسد، یک چالش طولانی برای محققان هوش مصنوعی (AI) بوده است. همانطور که بخش عصبی نشان میدهد، شبکه های عصبی از سیستم های هوش مصنوعی الهام گرفته از مغز هستند که قصد دارند تا راه هایی را که انسان ها میآموزند تکرار کنند. آنها شامل لایه های ورودی و خروجی میباشند و لایه هایی بین آنها ورودی را به خروجی صحیح تبدیل میکند. بعضی از شبکه های عصبی عمیق چنان پیچیده شدهاند که این روند غیرممکن را دنبال میکند. این به این دلیل است که آنها حتی برای سازندگانشان مانند جعبه سیاه سیستمی هستند.

با TbD-net، توسعه دهندگان قصد دارند این عملکرد داخلی را شفاف کنند. شفافیت مهم است زیرا به انسان اجازه میدهد تا نتایج یک تحقیق AI را تفسیر کند.

برای مثال مهم است که دقیقا روش کار یک شبکه عصبی که در ماشین های خود استفاده میکند را بدانند، این بینش به محققان اجازه میدهد تا شبکه عصبی را برای تصحیح هرگونه ناکارآمدی درست کنند. اما توسعه دهندگان TbD-net میگویند که امروزه شبکه های عصبی بهترین مکانیزم موثر برای توانمند سازی انسانها در درک فرایند استدلال خود را ندارند.

پیشرفت در بهبود عملکرد در استدلال بصری به هزینه تفسیر پذیری منجر شده است.

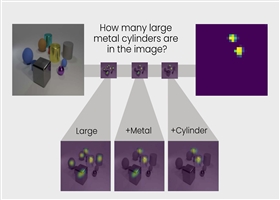

گروه آزمایشگاهی لینکلن توانست شکاف بین عملکرد و تفسیرپذیری با TbD-net را متوقف کند. سیستم آنها مجموعهای از ماژول های شبکه های عصبی کوچک است که برای انجام وظایف خاص متخصص هستند. وقتی از TbD-net یک سوال در مورد استدلال بصری درباره یک تصویر خواسته میشود، این سوال را به زیر کارها میشکند و ماژول مناسب را برای انجام بخش آن اختصاص میدهد. هر یک از ماژولها مثل کارگران در یک خط مونتاژ هستند، آنچه ماژول قبل از آن مشخص کرده است، نهایتا نتیجه نهایی و صحیح را تولید میکند. به طور کلی، TbD-net از یک تکنیک AI استفاده میکند که سوالات زبان انسانی را تفسیر میکند و این جملات را به زیر کارهای انجام میدهد و سپس تکنیک های AI بینش کامپیوتری که تصاویر را تفسیر میکنند بر میگرداند.

میومدار میگوید: شکستن یک زنجیره پیچیده از استدلال به یک سری معضلات کوچکتر که هر کدام میتوانند مستقل و متشکل شوند، یک ابزار قدرتمند و بصری برای استدلال است.

خروجی هر ماژول به صورت بصری در آنچه که گروه به آن توجه میکند، نشان داده میشود. ماسک ذکر شده نشانگرهای گرمای نقشه بر روی اشیاء در تصویر است که ماژول به عنوان پاسخ آن شناسایی میشود. این تجسمها اجازه میدهد تحلیلگر انسان ببیند چگونه یک ماژول تفسیر تصویر میکند.

به عنوان مثال، سوال زیر را برای TbD-net مطرح کنید: در این تصویر، چه رنگ مکعب بزرگ فلزی است؟ ماژول بعدی این خروجی را دریافت میکند و میبیند که کدامیک از اشیاء که توسط ماژول قبلی بزرگ شناخته شدهاند نیز فلز هستند. خروجی این ماژول به ماژول بعدی فرستاده میشود، که مشخص میکند که کدام یک از این اشیاء بزرگ، فلزی نیز یک مکعب است. در آخر، این خروجی به یک ماژول فرستاده میشود که میتواند رنگ اشیا را تعیین کند. خروجی نهایی TbD-net قرمز است، پاسخ صحیح به سوال.

هنگامی که آزمایش شد، TbD-net نتایجی را به دست آورد که بهترین مدل استدلال بینایی را پیشبینی کرده است. محققان مدل را با استفاده از یک مجموعه داده تصویری پاسخگو که شامل 70،000 تصویر آموزش و 700،000 سوال است، همراه با مجموعه های آزمون و اعتبار سنجی از 15،000 عکس و 150،000 سوال. مدل اولیه به 98 رسید. 7 درصد دقت آزمایش در مجموعه داده ها، که، طبق محققان، از دیگر روش های مبتنی بر شبکه مبتنی بر عصبی بسیار بهتر عمل میکند.

مهم این است که محققان توانستند این نتایج را به دلیل مزیت اصلی مدل خود یعنی شفافیت بهبود دهند. با نگاه کردن به ماسک های توجه تولید شده توسط ماژول ها، آنها میتوانند ببینند که همه چیز اشتباه گرفته شده و مدل را اصلاح کرده است. نتیجه نهایی عملکرد پیشرفتهای از 99 بود. 1 درصد دقت.

مدل ما خروجی های قابل تفسیر را در هر مرحله از فرآیند استدلال بصری فراهم میکند.

الگوریتم های یادگیری عمیق در کنار انسانها برای کمک به مقابله با وظایف دشوار دنیای واقعی که ارایه اطمینان میدهند ارزشمند هستند. برای ایجاد اعتماد به این سیستم ها، کاربران باید توانایی بازرسی فرایند استدلال را داشته باشند تا بتوانند درک کنند که چرا و چگونه یک مدل میتواند پیش بینی های اشتباه را انجام دهد.

پل متزر، رهبر گروه فناوری اطلاعات و تصمیم گیری، میگوید: پژوهش بخشی از کار آزمایشگاهی لینکلن برای تبدیل شدن به یک رهبر جهانی در تحقیقات علمی کاربردی ماشین آلات و هوش مصنوعی است که همکاری بین انسان و ماشین را ارتقا میبخشد. .

جزئیات این مقاله در مقاله Transparency by Design: closing gap between Performance and Interpretability in Reasoning Visual، که در کنفرانس دیدگاه کامپیوتر و شناخت الگو (CVPR) در تابستان امسال ارائه شد، شرح داده شده است.

لطفاً در مورد مطلب فوق ستاره بدهید :

طراحی سایت سیستم هوش مصنوعی از روشهای شفاف و مانند انسان برای حل مشکلات استفاده می کند Rated 3.9 / 5 based on 8 reviews.

آیا این مقاله برای شما مفید بود؟